一段话总结

随着语言预训练的发展,为降低成本并提升效率,本文提出Funnel-Transformer模型。该模型通过逐渐压缩隐藏状态序列长度减少计算量,将节省的计算资源用于构建更深或更宽的模型以提升能力,还设计解码器满足预训练时对每个token的预测需求。实验表明,在相似或更少的计算量下,Funnel-Transformer在多种序列级预测任务上优于标准Transformer,如文本分类、语言理解和阅读理解等。

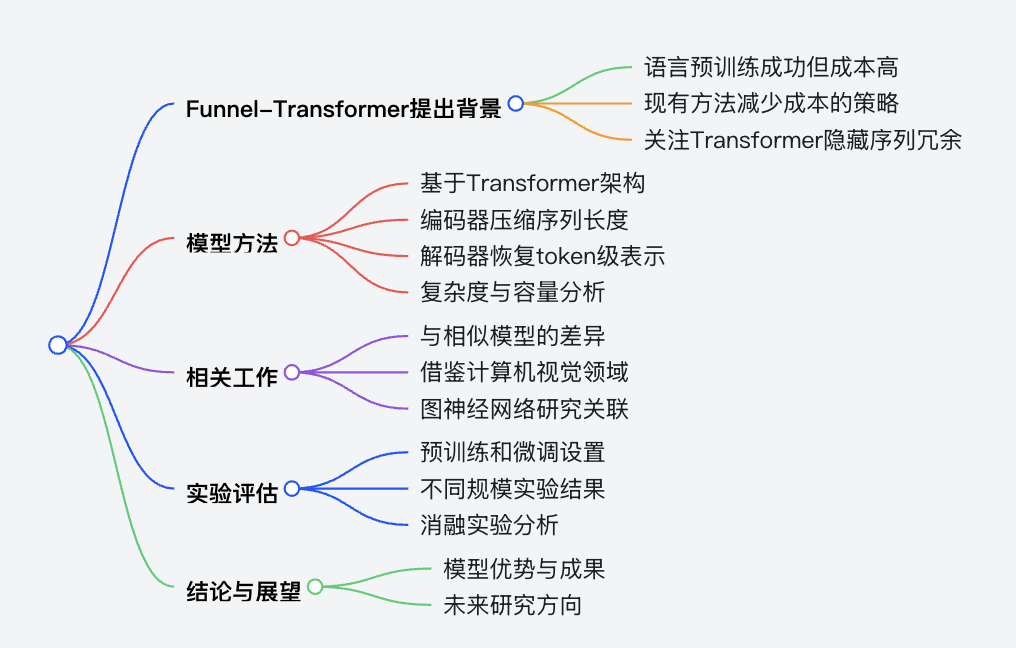

思维导图

详细总结

-

研究背景:语言预训练推动了自然语言处理的发展,但预训练和微调Transformer模型成本高昂,限制了其应用。当前减少成本的方法包括蒸馏、剪枝、量化以及设计高效架构等,本文聚焦于Transformer中隐藏状态序列的冗余问题。

-

Funnel-Transformer模型

- 架构:继承Transformer的整体结构,由编码器和解码器组成。编码器通过逐渐压缩隐藏状态序列长度来降低计算量,解码器用于恢复token级表示,以满足预训练任务需求。

- 编码器设计:编码器由多个Transformer层块组成,块内序列长度不变,块间通过特定池化操作减少序列长度。采用“pool-query-only”设计,用池化后的序列构建查询向量,未池化序列作为键值向量,增强了压缩效果。如使用步长为2、窗口大小为2的滑动窗口平均池化,可使序列长度减半。

- 解码器设计:对于需要token级预测的任务,解码器通过对编码器输出进行上采样,并结合第一层块的隐藏状态,形成深度token级表示。一般使用2个Transformer层来融合高低层特征。

- 复杂度与容量分析:序列压缩可显著降低计算复杂度,在相同计算量下可增加网络深度。虽然压缩会导致单层容量下降,但可通过堆叠更多层或增加模型宽度来弥补。不过,增加参数可能带来内存和通信成本的增加。

-

相关工作:与现有模型相比,Funnel-Transformer在序列长度压缩、池化和上采样设计等方面具有独特性。该模型还借鉴了计算机视觉领域的思想,同时与图神经网络中减少节点数量获取向量表示的研究相关。

-

实验评估

- 实验设置:预训练考虑基础规模(1M步,批次大小256)和大规模(500K步,批次大小8K)两种设置,微调主要关注序列级任务,包括GLUE基准、文本分类和阅读理解等任务,同时也测试了token级预测任务。

- 实验结果:在基础规模下,Funnel-Transformer在大多数任务上优于标准Transformer,尤其在较小模型中表现更优;大规模实验中,Funnel-Transformer在多数任务上也超越了基线模型,在RACE阅读理解任务中优势明显,但在需要详细token级信息的SQuAD任务中,对于大模型,Funnel-Transformer性能稍逊。

- 消融实验:研究了池化操作、“pool-query-only”设计、分离[cls]向量和相对位置注意力参数化等设计的重要性。发现平均池化和最大池化性能相似且优于基于注意力分数选择“hub”状态的池化方式;“pool-query-only”和分离[cls]向量能提升模型性能;相对位置注意力参数化对模型性能至关重要,3块设计的性能最佳。

-

结论与展望:Funnel-Transformer通过压缩序列分辨率节省计算资源并提升模型性能,但仍有改进空间,如优化压缩方案、块布局设计以及将其与其他模型压缩技术结合等。

| 模型 | 参数设置 | GLUE基准平均得分 | 文本分类错误率(IMDB) | FLOPs相对值 | 参数数量相对值 |

|---|---|---|---|---|---|

| L24H1024 | 24层,隐藏层大小1024 | 86.6 | 4.440 | 1.00x | 1.00x |

| B10-10-10 | 3块,每块10层,隐藏层大小1024 | 87.0 | 4.404 | 0.73x | 1.22x |

| L12H768 | 12层,隐藏层大小768 | 84.4 | 5.328 | 1.00x | 1.00x |

| B6-6-6 | 3块,每块6层,隐藏层大小768 | 85.3 | 4.908 | 0.88x | 1.39x |

关键问题

-

Funnel-Transformer模型中编码器的“pool-query-only”设计有什么优势?

- 答案:“pool-query-only”设计使压缩不仅取决于池化操作,还与自注意力对未池化序列的加权求和有关,能将T个基组合成较少的T'个“压缩基”,在最小计算开销下使压缩操作更具表现力,相比仅用池化操作控制压缩的朴素方法,能实现更好的压缩效果。

-

在实验中,Funnel-Transformer在不同规模设置下的表现如何?

- 答案:在基础规模下,Funnel-Transformer在多数任务上优于标准Transformer,尤其在较小模型中优势明显;在大规模设置下,Funnel-Transformer在多数任务上也超越了基线模型,在RACE阅读理解任务中优势显著,但在需要详细token级信息的SQuAD任务中,对于大模型,Funnel-Transformer性能稍落后于标准Transformer。

-

Funnel-Transformer模型未来的研究方向有哪些?

- 答案:未来可探索更好的压缩方案、优化块布局设计、研究如何更有效地重新分配节省的FLOPs以进一步提升模型性能。此外,将Funnel-Transformer与知识蒸馏和量化等模型压缩技术相结合,也是增强其实际应用效果的重要方向。